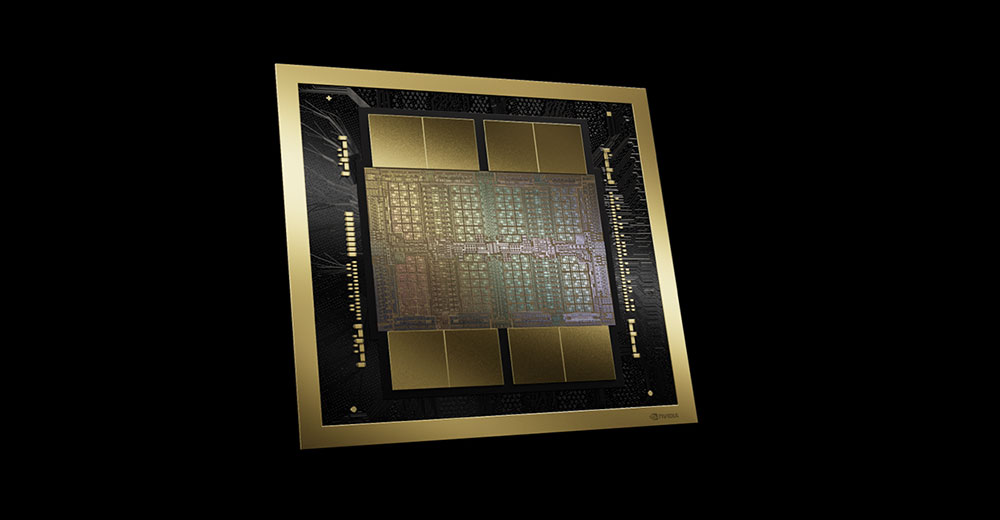

انویدیا با معرفی معماری بلک ول GPU خود در اولین کنفرانس حضوری فناوری GPU (GTC) در پنج سال گذشته، در حال افزایش قدرت در خط تراشه های هوش مصنوعی خود است.

به گفته انویدیا، تراشه ای که برای استفاده در مراکز داده بزرگ طراحی شده است – از نوع که قدرت هایی مانند AWS، Azure و Google را تامین می کند – عملکرد 20 پتافلاپ (PetaFLOPS) هوش مصنوعی را ارائه می دهد که 4 برابر سریعتر در بارهای آموزشی هوش مصنوعی، 30 برابر سریعتر در AI- استنتاج بارهای کاری و تا 25 برابر مصرف انرژی بیشتر از نسخه قبلی خود.

انویدیا معتقد است که B200 Blackwell در مقایسه با مدل قبلی خود، H100 “Hopper” قدرتمندتر و کارآمدتر از انرژی است. به عنوان مثال، برای آموزش یک مدل هوش مصنوعی به اندازه GPT-4، 8000 تراشه H100 و 15 مگاوات توان لازم است. همین کار تنها به 2000 تراشه B200 و چهار مگاوات قدرت نیاز دارد.

باب اودانل، بنیانگذار و تحلیلگر ارشد Technalysis Research، در خبرنامه هفتگی لینکدین خود نوشت: «این اولین پیشرفت بزرگ شرکت در طراحی تراشه از زمان معرفی معماری Hopper در دو سال پیش است.

تمرین بسته بندی مجدد

با این حال، سباستین ژان، مدیر ارشد فناوری Phison Electronics، یک شرکت الکترونیکی تایوانی، این تراشه را “یک تمرین بسته بندی مجدد” نامید.

او به TechNewsWorld گفت: «خوب است، اما پیشگامانه نیست. سریعتر کار میکند، انرژی کمتری مصرف میکند و امکان محاسبات بیشتری را در یک منطقه کوچکتر فراهم میکند، اما از دیدگاه فنآوران، آنها فقط آن را کوچکتر کردند بدون اینکه واقعاً هیچ چیز اساسی تغییر کند.»

او گفت: “این بدان معناست که نتایج آنها به راحتی توسط رقبای آنها تکرار می شود.” “اگرچه اول بودن ارزش دارد، زیرا در حالی که رقابت شما پیش می آید، به سراغ چیز بعدی می روید.”

او گفت: «وقتی شما رقابت خود را مجبور به یک بازی دائمی میکنید، مگر اینکه رهبری بسیار قوی داشته باشند، بدون اینکه متوجه شوند در ذهنیت «پیرو سریع» قرار میگیرند.

او ادامه داد: «انویدیا با تهاجمی بودن و اول بودن میتواند این ایده را تقویت کند که آنها تنها نوآوران واقعی هستند که باعث افزایش تقاضا برای محصولاتشان میشود.»

او افزود، اگرچه بلک ول ممکن است یک تمرین بسته بندی مجدد باشد، اما سود خالص واقعی دارد. او خاطرنشان کرد: از نظر عملی، افرادی که از بلکول استفاده میکنند میتوانند با همان قدرت و بودجه فضایی، محاسبات بیشتری را سریعتر انجام دهند. “این به راه حل های مبتنی بر Blackwell اجازه می دهد تا از رقبای خود پیشی بگیرند و عملکرد بهتری داشته باشند.”

پلاگین سازگار با گذشته

O'Donnell اظهار داشت که موتور ترانسفورماتور نسل دوم معماری بلک ول یک پیشرفت قابل توجه است زیرا محاسبات نقطه شناور هوش مصنوعی را از هشت بیت به چهار بیت کاهش می دهد. او گفت: «از لحاظ عملی، با کاهش این محاسبات از 8 بیت در نسلهای قبلی، آنها میتوانند عملکرد محاسباتی و اندازههای مدلی را که میتوانند در Blackwell پشتیبانی کنند، با این تغییر واحد دو برابر کنند.

تراشه های جدید نیز با نسخه های قبلی خود سازگار هستند. جک ای گلد، بنیانگذار و تحلیلگر اصلی J.Gold Associates، یک شرکت مشاوره فناوری اطلاعات در Northborough، ماساچوست، اظهار داشت: «اگر قبلاً سیستمهای Nvidia را با H100 دارید، بلکول با پلاگین سازگار است.

او به TechNewsWorld گفت: «در تئوری، شما فقط میتوانید H100s را جدا کنید و Blackwells را وصل کنید. اگرچه از نظر تئوری می توانید این کار را انجام دهید، اما ممکن است از نظر مالی نتوانید این کار را انجام دهید. به عنوان مثال، تراشه H100 انویدیا هر کدام 30 تا 40 هزار دلار قیمت دارد. اگرچه انویدیا قیمت خط جدید تراشه هوش مصنوعی خود را فاش نکرد، اما احتمالاً قیمت گذاری در همین راستا خواهد بود.

گلد اضافه کرد که تراشه های بلک ول می توانند به توسعه دهندگان کمک کنند تا برنامه های هوش مصنوعی بهتری تولید کنند. او توضیح داد: «هرچه بتوانید نقاط داده بیشتری را تجزیه و تحلیل کنید، هوش مصنوعی بهتر می شود. چیزی که انویدیا با بلک ول درباره آن صحبت می کند این است که به جای توانایی تجزیه و تحلیل میلیاردها نقطه داده، می توانید تریلیون ها را تجزیه و تحلیل کنید.

همچنین در GTC Microservices استنتاج انویدیا (NIM) معرفی شد. برایان کوللو، استراتژیست سهام در پژوهش مورنینگ استار، «ابزارهای NIM بر روی پلتفرم CUDA انویدیا ساخته شدهاند و به کسبوکارها این امکان را میدهد تا برنامههای کاربردی سفارشی و مدلهای هوش مصنوعی از پیش آموزشدیده را به محیطهای تولید بیاورند، که باید به این شرکتها در ارائه محصولات جدید هوش مصنوعی به بازار کمک کند». سرویس، در شیکاگو، در یادداشت یک تحلیلگر سه شنبه نوشت.

کمک به استقرار هوش مصنوعی

شرکتهای بزرگ با مراکز داده میتوانند سریعتر فناوریهای جدید را اتخاذ کرده و سریعتر به کار گیرند، اما بیشتر انسانها در مشاغل کوچک و متوسط هستند که منابع لازم برای خرید، سفارشیسازی و استقرار فناوریهای جدید را ندارند. شین راو، تحلیلگر نیمه هادی IDC، یک شرکت تحقیقاتی بازار جهانی، توضیح می دهد که هر چیزی مانند NIM که بتواند به آنها کمک کند فناوری جدید را بپذیرند و آسان تر آن را به کار گیرند، برای آنها مفید خواهد بود.

او به TechNewsWorld گفت: «با NIM، مدلهای خاص کاری را که میخواهید انجام دهید پیدا خواهید کرد. همه نمی خواهند به طور کلی هوش مصنوعی انجام دهند. آنها میخواهند هوش مصنوعی انجام دهند که به طور خاص به شرکت یا شرکت آنها مرتبط باشد.»

در حالی که NIM به اندازه جدیدترین طراحیهای سختافزاری هیجانانگیز نیست، اودانل خاطرنشان کرد که به دلایل متعددی در درازمدت اهمیت بیشتری دارد.

او نوشت: «ابتداً، قرار است حرکت شرکتها از آزمایشهای GenAI و POC (اثبات مفاهیم) به تولید در دنیای واقعی، سریعتر و کارآمدتر شود. به سادگی دانشمندان داده و کارشناسان برنامه نویسی GenAI کافی برای دور زدن وجود ندارد، بنابراین بسیاری از شرکت هایی که مشتاق به استقرار GenAI بوده اند به دلیل چالش های فنی محدود شده اند. در نتیجه، دیدن کمک انویدیا به تسهیل این فرآیند بسیار عالی است.»

او ادامه داد: «دوم، این میکروسرویسهای جدید امکان ایجاد یک جریان درآمدی جدید و استراتژی کسبوکار را برای انویدیا فراهم میکنند، زیرا میتوانند بر اساس هر GPU/در ساعت مجوز بگیرند (و همچنین سایر تغییرات). این میتواند وسیلهای مهم، طولانیمدت و متنوعتر برای کسب درآمد برای انویدیا باشد، بنابراین حتی اگر روزهای ابتدایی است، تماشای آن بسیار مهم است.

رهبر ریشه دار

راو پیش بینی کرد که انویدیا به عنوان پلتفرم پردازش هوش مصنوعی انتخابی برای آینده قابل پیش بینی باقی خواهد ماند. او گفت: «اما رقبایی مانند AMD و Intel قادر خواهند بود بخشهای متوسطی از بازار پردازندههای گرافیکی را در اختیار بگیرند. و از آنجایی که تراشه های مختلفی وجود دارد که می توانید برای هوش مصنوعی از آنها استفاده کنید – ریزپردازنده ها، FPGA ها و ASIC ها – آن فناوری های رقیب برای سهم بازار و رشد با یکدیگر رقابت خواهند کرد.

عبدالله انور احمد، بنیانگذار Serene Data Ops، یک شرکت مدیریت داده در سانفرانسیسکو، افزود: “تهدیدهای بسیار کمی برای تسلط انویدیا در این بازار وجود دارد.”

او به TechNewsWorld گفت: “علاوه بر سخت افزار برتر آنها، راه حل نرم افزاری آنها CUDA پایه و اساس بخش های زیربنایی هوش مصنوعی برای بیش از یک دهه بوده است.”

او ادامه داد: «تهدید اصلی این است که آمازون، گوگل و مایکروسافت/OpenAI در حال کار بر روی ساخت تراشههای خود بهینهسازی شده بر اساس این مدلها هستند. گوگل در حال حاضر تراشه TPU خود را در دست تولید دارد. آمازون و OpenAI به پروژه های مشابه اشاره کرده اند.

او افزود: «در هر صورت، ساختن GPUهای شخصی یک گزینه تنها در اختیار بزرگترین شرکتها است. “بیشتر صنعت LLM به خرید پردازنده های گرافیکی Nvidia ادامه خواهد داد.”